Почему в 2026‑м все снова говорят о тестировании производительности

Если в нулевые нагрузочное тестирование ассоциировалось только с энтерпрайзом и конструкциями вида «закупим лицензии и прожжем бюджет», то к 2026 году ситуация поменялась радикально: микросервисы, Kubernetes, облачные автоскейлеры и глобальные релизы за один день привели к тому, что измерять производительность стали даже маленькие продуктовые команды. При этом платить тысячи долларов за тулзинг готов не каждый, поэтому спрос на бесплатные инструменты для нагрузочного тестирования обогнал по популярности многие коммерческие решения. Исторически путь был такой: сначала дорогой HP LoadRunner, потом более демократичный JMeter, дальше волна облачных SaaS и, наконец, зрелая экосистема open source, где можно собрать стек под себя без лишних затрат, но при этом не потерять в качестве метрик и глубине анализа системных узких мест.

Краткий исторический экскурс: от монолитов к облачным сценариям

В конце 90‑х и начале 2000‑х тестирование производительности было уделом крупных банков и телекомов: толстые монолиты, вертикальное масштабирование, капитальные лицензии на толстых клиентах. Затем появился Apache JMeter и фактически задал стандарт для «массового» подхода: сценарии в виде деревьев, протокол HTTP(S), первые интеграции с CI. Позже в игру вошли Gatling и Locust, которые принесли программируемые сценарии и моделирование сложных пользовательских профилей. С распространением контейнеров и DevOps‑культурой нагрузка стала частью конвейера, а лучшее бесплатное программное обеспечение для тестирования производительности стало тем самым «обязательным инструментом», как Git или Docker. Сейчас команды стремятся не просто один раз прогнать стресс‑тест, а встроить его в регулярные регрессы, сравнивая тренды RPS, latency и ошибок между релизами.

Как понять, какое бесплатное решение реально подойдет вашей инфраструктуре

Глупо искать волшебный универсальный тул, важнее сначала описать собственный контекст: стек технологий, профиль трафика, требования по масштабируемости и ограничения по времени инженеров. Один проект живет на legacy‑монолите с тяжелыми SQL‑запросами, другой крутится на serverless‑функциях с пиковыми всплесками и «холодными стартами», третий использует очереди и event‑driven архитектуру. В каждом случае критерии выбора инструмента меняются: где‑то важна поддержка протоколов вроде gRPC и WebSocket, где‑то нужно удобное управление сессиями и куками, а иногда критичен простой запуск из CI без лишней ручной работы. Перед тем как скачать бесплатный софт для стресс-тестирования сервера, полезно расписать типовые сценарии нагрузки: авторизация, поиск, массовый импорт данных, критические API‑эндпоинты; и на их основе оценивать удобство создания и параметризации тестов в конкретном продукте.

На что смотреть в функциональности: сценарии, масштабирование, метрики

Условно требования можно разделить на три блока: моделирование поведения, масштабирование генерации трафика и сбор наблюдаемости. В моделировании ключевые вопросы — поддержка сложных сценариев с ветвлениями, корреляцией параметров и динамическими данными, а также наличие понятного DSL или GUI для менее опытных тестировщиков. В части масштабирования стоит проверить, как инструмент распределяет нагрузку по нескольким агентам, умеет ли запускаться в контейнерах и оркестраторах, насколько стабилен при высоком RPS. Для метрик важна не только средняя задержка, но и перцентили, профиль отказов, breakdown по эндпоинтам, а также возможность экспорта в Prometheus, Grafana или аналогичные системы. Многие open source инструменты для тестирования нагрузки и производительности уже «из коробки» умеют слать метрики по HTTP или через push‑gateway, что упрощает интеграцию в существующий стек наблюдаемости.

Когда хватит десктопа, а когда нужны облако и online‑сервисы

Локальный запуск хорош, пока вы моделируете небольшую нагрузку или дебажите сам сценарий, но как только речь заходит о геораспределенном трафике или десятках тысяч виртуальных пользователей, возникают лимиты по каналам, железу и сложность сетевой топологии. Здесь в игру вступают online сервисы для тестирования производительности сайта бесплатно: они берут на себя генерацию трафика из разных регионов, агрегацию результатов и визуализацию, а иногда еще и автоматический поиск кореляций между параметрами. Однако у них есть свои ограничения по глубине настройки и безопасности данных. Зачастую оптимальная схема — гибридная: основной сценарий и логика остаются в открытом инструменте, который вы можете запускать в собственном Kubernetes‑кластере, а «быстрые замеры» фронта или лендингов делаете через SaaS, не затрагивая внутренние API и приватные данные пользователей в проде.

Типичные ошибки при выборе бесплатных инструментов и как их избежать

Частая ловушка — ориентироваться только на удобный интерфейс или громкую популярность, игнорируя реальные ограничения протоколов и сценариев. Например, команда выбирает тул с красивым GUI, а затем выясняет, что нужно полноценно тестировать streaming‑эндпоинты или бинарный протокол, для которого потребуется писать костыли и прокси. Еще ошибка — не учитывать future‑proof‑аспект: сейчас достаточно одного сервиса, а через полгода появляется микросервисный зоопарк, и уже нужно масштабировать нагрузку в несколько параллельных контуров. Наконец, многие забывают про интеграцию с CI/CD: если инструмент плохо дружит с GitLab CI, GitHub Actions или Jenkins, нагрузочные тесты так и останутся «ручным ритуалом» перед крупным релизом, вместо того чтобы стать частью pipeline, который автоматически сравнивает результаты с базовыми контрольными значениями и валит сборку при деградации SLA.

Практический чек‑лист перед финальным выбором тулза

Чтобы не утонуть в бесконечных обзорах, удобнее пройтись по конкретным вопросам и поставить «да/нет» для каждого инструмента. Полезно проверить:

• Умеет ли он описывать сценарии в человекочитаемом виде (DSL, YAML, код на знакомом языке).

• Есть ли поддержка нужных протоколов и типов трафика: REST, gRPC, WebSocket, GraphQL, очереди.

• Насколько просто автоматизировать запуск из CI, параметризовать окружения и изменять интенсивность нагрузки.

• Может ли инструмент масштабироваться горизонтально: запуск нескольких генераторов, интеграция с контейнерами.

• Какие метрики и отчеты доступны, есть ли экспорт в вашу систему мониторинга.

• Не привязывает ли тул вас к вендору, и можно ли мигрировать сценарии в другой стек без тотальной переписки. Такой чек‑лист быстрее подсветит реальное лучшее бесплатное программное обеспечение для тестирования производительности под вашу архитектуру, чем десятки маркетинговых обзоров.

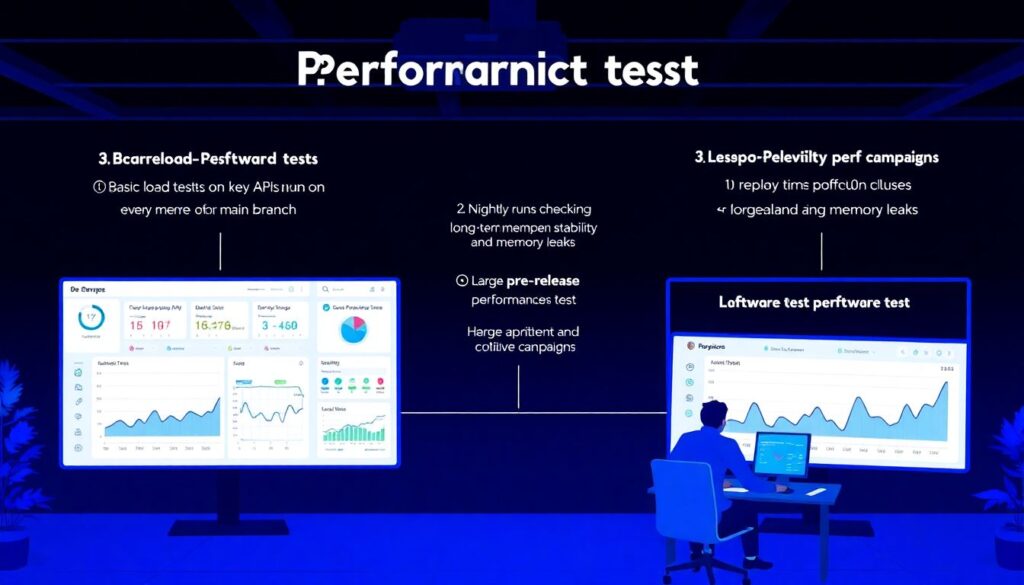

Как встроить бесплатные инструменты в зрелый процесс тестирования

Сама по себе возможность бесплатно прогнать нагрузку мало что дает, если это разовый эксперимент. Гораздо эффективнее выстроить контур: базовые тесты на ключевые API запускаются на каждом merge в основную ветку, nightly‑прогоны проверяют долговременную стабильность и утечки памяти, а перед крупным релизом выполняется расширенный стресс‑тест с моделированием пиковых событий. Для этого сценарии хранятся в репозитории рядом с кодом, конфиги окружений версионируются, а результаты автоматически попадают в дэшборды с историей. Постепенно команда накапливает артефакты: профили нагрузки, эталонные значения per‑endpoint latency, привычные графики CPU/IO под обычным и пиковым трафиком; и на этом фоне становится заметна любая деградация. Именно так бесплатные инструменты для нагрузочного тестирования перестают быть «игрушкой» и превращаются в полноценную часть инженерной культуры, куда органично вписываются и облачные сервисы, и локальный open source‑инструментарий, и внутренние практики performance‑ревью для каждого релиза.