Зачем вообще разбираться с бесплатным анализом данных

Когда речь заходит про аналитику, многим кажется, что без дорогих лицензий путь закрыт. На практике же огромное количество задач спокойно решается через бесплатные инструменты для анализа данных, и ограничения чаще упираются не в функционал, а в навыки и организацию процесса. Важно понять: бесплатное не значит примитивное. То, что крупные компании используют платные платформы, связано не только с возможностями, но и с поддержкой, интеграциями и регламентами безопасности. Для небольших команд, студентов, исследователей и стартапов лучшее бесплатное программное обеспечение для анализа данных нередко оказывается даже удобнее: оно более гибкое, расширяемое, а сообщество охотно делится готовыми решениями и примерами.

Готовые пакеты против конструкторов: два подхода

Существует два больших подхода. Первый — использовать «комбайны»: условно говоря, установил программу, подключил файлы, нажал пару кнопок и получил дашборд. Второй — собирать свой стек из отдельных модулей: одно ПО для подготовки данных, другое для расчётов, третье для визуализации. Первый вариант любят те, кто хочет минимизировать настройки и быстрее увидеть результат, второй нравятся тем, кто ценит гибкость и контроль. Если провести мысленное сравнение бесплатных программ для анализа данных, то быстро видно: готовые пакеты проще на старте, но сложнее расширяются; конструкторы требуют больше усилий сначала, зато потом подстраиваются почти под любую задачу, от маркетинговых отчётов до исследований в науке.

Необходимые инструменты

Базовый набор: таблицы, скрипты и визуализация

Минимальный набор, без которого анализ вряд ли получится продуктивным, включает три элемента: табличный редактор, язык для обработки данных и средство визуализации. В роли табличного редактора чаще всего выступает LibreOffice Calc или его аналоги — для простых сводных отчётов этого более чем достаточно. Для сложных сценариев многие выбирают Python с библиотеками pandas и matplotlib: это классический пример того, как open source инструменты для аналитики данных превращают обычный ноутбук в мощную лабораторию. Для визуализации можно подключить дополнительные библиотеки вроде seaborn или Plotly, получая интерактивные графики, которые не стыдно показать инвесторам или руководству.

Специализированные аналитические платформы

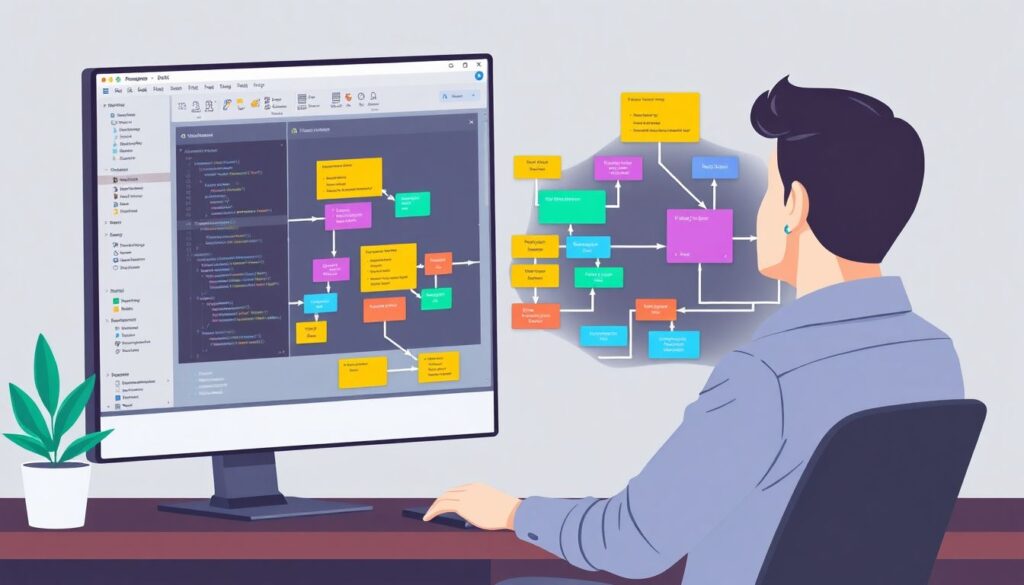

Если не хочется глубоко уходить в программирование, на помощь приходят специализированные решения, многие из которых распространяются бесплатно. KNIME и Orange — типичные представители: перетаскиваете блоки-узлы, соединяете стрелками и собираете весь процесс анализа, как конструктор. Такой визуальный подход снижает порог входа и одновременно дисциплинирует: pipeline анализа становится наглядным и воспроизводимым. Подобные системы нередко называют лучшее бесплатное программное обеспечение для анализа данных для тех, кто привык мыслить блок-схемами, а не кодом. Они же позволяют мягко перейти к более продвинутым методам вроде машинного обучения, не меняя принцип работы и не теряя уже собранные сценарии.

Хранилища и работа с объёмными данными

Когда данные перестают помещаться в одну таблицу, появляются новые требования: нужно хранить, фильтровать и быстро извлекать информацию. Здесь в игру вступают системы управления базами данных — PostgreSQL, MySQL, SQLite и другие. Они тоже бесплатные, но уже требуют чуть большего понимания принципов структурирования данных. При грамотном подходе аналитик комбинирует БД как «двигатель» хранения и тот же Python, R или визуальные среды для расчётов. Интересно, что во многих случаях нет нужды сразу бежать в «большие данные» и сложные кластеры: правильная схема базы и продуманные запросы позволяют удивительно многого добиться на обычном сервере, не переплачивая за инфраструктуру.

Поэтапный процесс анализа данных

От постановки задачи к сбору и очистке данных

Поэтапный процесс работы почти всегда начинается не с кода, а с формулировки вопроса: что именно хотим понять. После этого подбираются источники: базы, API, файлы, логи. Дальше — рутинный, но критически важный этап очистки. Даже когда вы решаете скачать бесплатные программы для анализа данных и сразу «запустить модель», без чистых данных результаты окажутся хрупкими и противоречивыми. Здесь помогают как табличные редакторы, так и скрипты: удаление дубликатов, обработка пропусков, унификация форматов дат, кодировок и категорий. На этом шаге полезно сразу зафиксировать логику преобразований, чтобы в будущем можно было повторить обработку на новых данных без ручной возни.

Исследовательский анализ и выбор инструментов

После первичной очистки наступает момент разведочного анализа: строятся гистограммы, диаграммы рассеяния, считаются базовые статистики. Это позволяет нащупать закономерности и аномалии, заметить выбросы и странные сегменты. На этом этапе становится ясно, какие именно инструменты нужны дальше: где-то достаточно сводных таблиц и парочки графиков, а где-то требуется регрессия, кластеризация или временные ряды. Важно, что open source инструменты для аналитики данных позволяют быстро переключаться между подходами: пробовать разные модели, тестировать гипотезы и сравнивать результаты без дополнительных расходов, ограничиваясь временем и вычислительными ресурсами.

Автоматизация и внедрение в рабочий процесс

Когда процесс устоялся, логично перейти к автоматизации. Скрипты превращаются в регулярные задачи, настроенные по расписанию, а визуализации собираются в дашборды, обновляющиеся без ручного вмешательства. Здесь особенно полезно провести вдумчивое сравнение бесплатных программ для анализа данных: одни лучше подходят для разового исследования, другие ориентированы на постоянный мониторинг. Одни инструменты легко встраиваются в существующую IT-инфраструктуру и системы отчётности, другие требуют обходных путей. В идеале итоговый конвейер должен быть понятен не только автору, но и любому коллеге, который в будущем окажется ответственным за поддержку и развитие аналитики.

Устранение неполадок и типичные «грабли»

Проблемы с установкой и совместимостью

Самые приземлённые сложности, с которыми сталкиваются пользователи, касаются установки: зависимости, версии библиотек, несовместимость пакетов. Здесь удобнее всего разделить окружения: для Python — использовать виртуальные среды, для аналитических платформ — отдельные каталоги и чёткую документацию по версиям. На первый взгляд это лишняя бюрократия, но она экономит часы, когда внезапно перестаёт работать старый проект после обновления библиотеки. Ещё одна распространённая ошибка — хаотичное скачивание и установка всего подряд: разумнее заранее определить, какие именно бесплатные инструменты для анализа данных действительно нужны под конкретные задачи.

Ошибки в данных и неправильные выводы

Куда коварнее технических багов логические ошибки. Некорректно сгруппировали данные, забыли учесть сезонность, перепутали единицы измерения — и уже строятся уверенные, но ложные выводы. Многие бесплатные решения не навязывают жёстких ограничений, и это плюс свободы, но одновременно риск. Полезная привычка — обязательно дублировать ключевые вычисления разными методами или хотя бы разными инструментами. Если простой расчёт в таблице подтверждает результат кода, доверия к выводу становится больше. В спорных случаях лучше потратить время на перепроверку и обсуждение методики с коллегами, чем потом объяснять, почему стратегия построена на ошибочной аналитике.

Когда бесплатного уже не хватает

Иногда команда доходит до точки, когда упирается в ограничения: по скорости, безопасности или требованиям регуляторов. В этот момент важно трезво оценить, где узкое место — в инструментах или в архитектуре. Нередко оказывается, что грамотное перераспределение задач между компонентами стека снимает проблему без покупки платного ПО. Однако если бизнесу нужны, например, сертифицированные решения, официальная поддержка 24/7 или готовые интеграции с десятками корпоративных систем, переход на коммерческие платформы становится оправданным. При этом опыт, полученный на бесплатных инструментах, никуда не исчезает: понимание процессов, умение работать с данными и строить модели остаётся ключевым активом, независимо от выбранного набора программ.